Big-Data-Analysen multimorbider Patienten

Aktuelle Studien zu Big Data-Analysen in der Medizin zeigen vielversprechende Ergebnisse in Hinblick auf die Genauigkeit der Prognosen und lassen sie zum aktuellen Zeitpunkt als sinnvolle Ergänzung in der Versorgungsforschung erscheinen.

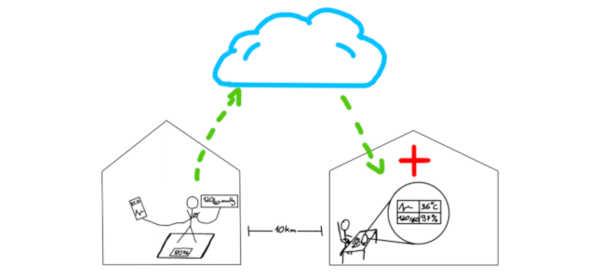

Im Rahmen des Teilprojekts „Big Data“ wird sich in mehreren Arbeitspaketen der Frage genähert, ob die Analyse von komplexen Patientendaten dabei helfen kann, die Versorgung von Patienten zu verbessern.

Die Prozessevaluation dieses Arbeitspaketes wird auch die datenschutzrechtlichen und ethischen Fragestellungen die dieses Vorgehen aufwirft, adressieren.

Aus der Perspektive der Informatik zeigt der aktuelle Forschungsstand zu diesem Themenkomplex, dass es bei Nutzung von Big Data Analysen nicht einfach möglich ist, Funktionen durch von Menschen erstellte Algorithmen zu berechnen. Es werden daher automatische Verfahren zur Herleitung von Berechnungsverfahren von Funktionen verwendet. Automatisch aus Trainingsdaten berechnete („gelernte“) Funktionen, wie z.B. Klassifikatoren, Regressionsfunktionen usw., sind durch verschiedene Leistungsmaße gekennzeichnet, z.B. Verlustmaße, Fehlermaße, Präzision und Trefferquote oder auch Falsch-Positiv- und Falsch-Negativ-Raten, um nur einige zu nennen.

Dabei ist zu beachten, dass tatsächlich große Datenmengen herangezogen werden müssen, um z. B. bei vielen Datenmerkmalen (also einer hohen Datendimension) die notwendige Unabhängigkeit in den Trainingsdaten zu gewährleisten. Es ist wohlbekannt, dass z.B. bei Vorgaben für die Größe eines Konfidenzintervalls eines Tests ein Mindestmaß an (unabhängigen) Daten verwendet werden muss, um die Anforderungen zu erfüllen. Bei Verwendung von (kleinen) Stichproben als Basis für Lernverfahren (etwa mit Kreuzvalidierung) kann aufgrund der fehlenden Unabhängigkeit der Trainingsdaten häufig ein bestimmtes Gütemaß nicht überschritten werden. Sehr oft reicht daher die Leistung von aus Stichprobendaten gelernten Funktionen daher in praktischen Anwendungen nicht aus.

Die aus diesem Vorgehen gewonnenen Lernprozesse für Funktionen basieren auf einer Datenverteilung, die zur Entwicklungszeit vorliegt, und man nimmt an, dass zur Verwendungszeit der gelernten Funktionen die gleiche oder eine zumindest annäherungsweise gleiche Verteilung vorliegt, so dass mit hoher Wahrscheinlichkeit eine kleine Fehlerrate erzielt werden kann. Nicht in allen Fällen ist die Annahme allerdings gerechtfertigt. In vielen Fällen muss eine Funktion zur Verwendungszeit angepasst werden. Eine Anpassung kann durch überwachtes oder auch nicht-überwachtes Lernen inkrementell erfolgen.

Projektbeteiligte

Alexander Waschkau

Institut für Allgemeinmedizin (IfA)

+49 451 3101 8014

alexander.waschkau(at)uni-luebeck.de

Jost Steinhäuser

Institut für Allgemeinmedizin (IfA)

+49 451 3101 8000

Jost.steinhaeuser(at)uksh.de

Katja Götz

Institut für Allgemeinmedizin (IfA)

+49 451 3101 8010

Katja.goetz(at)uni-luebeck.de

Marcel Gehrke, M. Sc.

Institut für Informationssysteme (IFIS)

+49 451 3101 5714

gehrke(at)ifis.uni-luebeck.de

- Forschung

- Joint Labs

- Projekte

- Aktuelle Projekte

- Abgeschlossene Projekte

- ACTIVATE

- Ambient Care

- Big-Data-Analysen multimorbider Patienten

- DISH

- ParkProTrain

- Publikationen

- Umfragen

Projektleitung

Ralf Möller

Institut für Informationssysteme (IFIS)